Techniki manipulacji w świecie deepfake'ów - jak sztuczna inteligencja zmienia oblicze dezinformacji

16.05.2025

Dynamiczny rozwój sztucznej inteligencji (AI) i coraz powszechniejszy dostęp do narzędzi opartych na AI niesie ze sobą wiele zagrożeń. Technologia deepfake staje się groźnym narzędziem manipulacji. Umożliwia tworzenie fałszywych filmów i nagrań, w których znane osoby rzekomo wypowiadają się lub polecają produkty. Treści te są masowo rozpowszechniane w sieci i mogą wprowadzać odbiorców w błąd. W rękach niewłaściwych osób może wpływać na zbiorowe zachowania całych grup społecznych i indywidualnych odbiorców, narażając ich na straty moralne i nierzadko materialne.

Ewelina Bartuzi-Trokielewicz, naukowczyni w NASK-Państwowym Instytucie Badawczym, kierująca Zakładem Analiz Audiowizualnych i Systemów Biometrycznych, specjalizująca się w uczeniu głębokim, widzeniu komputerowym, analizie dźwięku, biometrii i pogłębionej analizie deepfake'ów, członkini sekcji AI, prawa człowieka i demokracja w Grupie Roboczej ds. sztucznej inteligencji i internetu rzeczy „GRAI” przybliża techniki manipulacji, wykorzystywane w syntetycznych materiałach audiowizualnych.

Sztuczna inteligencja zmieniła sposób, w jaki pracujemy, komunikujemy się i podejmujemy decyzje. Wspomaga ludzi w wielu dziedzinach, automatyzując procesy, przyspieszając analizę danych i wspierając codzienne działania. Niestety, coraz częściej obserwujemy jej wykorzystanie do kompleksowej manipulacji ludzką percepcją, czego przykładem jest technologia deepfake, która pozwala na tworzenie syntetycznych danych, realistycznie odwzorowując prawdziwe materiały.

Modele generatywne umożliwiają m.in. tworzenie lub modyfikację obrazów i dźwięków. Ludzie mają naturalną skłonność do ufania temu, co widzą i słyszą, dlatego zjawisko to jest szczególnie niebezpieczne w dobie społeczeństwa cyfrowego, które jest przyzwyczajone do audiowizualnego przekazu informacji i korzysta z Internetu jako głównego źródła wiedzy o świecie.

Dodatkowo, metody tworzenia deepfake’ów są dziś łatwo dostępne, tanie i niewymagające specjalistycznej wiedzy. Narzędzia oparte na AI pozwalają generować realistyczne fałszywe treści w kilka minut – bez konieczności inwestowania w sprzęt, dane treningowe czy infrastrukturę IT. Konsekwencją tego są fałszywe materiały, które można produkować masowo niskim kosztem, a następnie rozpowszechniać w mediach społecznościowych, komunikatorach i serwisach wideo, docierając do setek tysięcy odbiorców w krótkim czasie.

Deepfake kojarzy się głównie z manipulacją obrazu, w szczególności twarzy – czyli podmianą wizerunku lub sterowaniem mimiki. Równie groźne są techniki manipulacji głosem, pozwalające odtworzyć mowę dowolnej osoby (tzw. voice cloning), oraz łączone materiały audio-wideo, w których sztucznie wygenerowany głos i mimika (wraz z ruchem ust) współgrają ze sobą, tworząc bardzo realistyczne filmy. To ważne by rozumieć mechanizmy i techniki manipulacji, które stoją za syntetycznymi materiałami.

Główne obszary manipulacji dotyczą:

- wykorzystania wizerunków znanych osób,

- modyfikacji treść przekazu oraz

- dopasowania kontekstu i form.

Manipulacja tożsamością

Najpotężniejszą formą manipulacji wykorzystującą generatywną sztuczną inteligencję jest wykorzystanie wizerunku autorytetu, czyli osób, które wzbudzają zaufanie i automatyczne zwiększają wiarygodności przekazu. W materiałach propagujących treści dezinformacyjne spotykamy różne formy autorytetów:

- publiczne – powszechnie znane i darzone zaufaniem osoby, których opinie mają dużą wagę w społeczeństwie, np. politycy, sportowcy, dziennikarze,

- eksperci dziedzinowi – specjaliści określonych dziedzin, których wiedza i doświadczenie są uznawane przez społeczność fachową, np. lekarze, ekonomiści, profesorowie.

- osoby bliskie autorytetom –powiązane z autorytetami publicznymi, m.in. współpracownicy, członkowie rodziny, przyjaciele, których opinie mogą być wiarygodne na skutek powiązania członkowie rodziny, współpracownicy,

- przeniesione – osoby, które będąc autorytetem w jednej dziedzinie, wypowiadają się na tematy inne, niezwiązane z dziedziną ekspercką,

- auto-autorytety – przedstawianie siebie jako eksperta, aby uzyskać pozytywny przekaz i przyciągnąć uwagę,

- reprezentanci grup – przedstawiciele grup, instytucji, rządu, których wypowiedzi mają być postrzegane jako głos całej zbiorowości lub społeczeństwa.

Do tego rodzaju manipulacji używa się technik podmiany twarzy, klonowania głosu, modyfikacji tzw. artybutów, które pozwalają na dopasowanie ruchu ust i mimiki do zmodyfikowanej ścieżki głosowej, a także tworzenia całkowicie syntetycznych postaci, tzw. avatarów.

Wykorzystanie autorytetów służy wzbudzeniu natychmiastowego zaufania i często też odciąga uwagę od treści – odbiorca reaguje na „twarz”, bez analizowania przekazu.

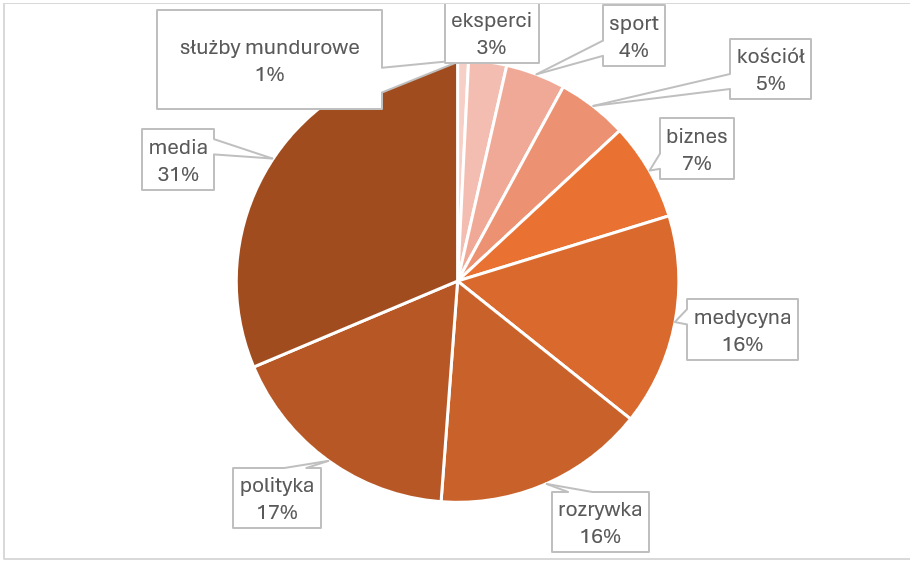

Technologie generatywne stają się jednym z najskuteczniejszych narzędzi manipulacji informacją. Łącząc realistyczną oprawę audiowizualną z technikami manipulacji, mogą wpływać na emocje, decyzje, czy nawet na przekonania odbiorców. NASK-PIB we współpracy z KNF CSIRT zidentyfikował ponad 13 tysięcy fałszywych materiałów, głównie reklamowych. Niemal 60% z nich dotyczyło rzekomych instrumentów finansowych i programów rządowych, gdzie wykorzystano ponad 280 wizerunków znanych osób.

Rysunek 1. Wykres przedstawiający procentowy rozkład grup ludzi, których wizerunki zostały wykorzystane w fałszywych reklamach publikowanych na mediach społecznościowych i fałszywych stronach internetowych, obejmując analizę materiałów audiowizualnych zebranych przez 12 miesięcy (ponad 13 tysięcy fałszywych linków do reklam, gdzie unikalne treści stanowiły ok. 650 filmów.

Manipulacja treścią przekazu

Treści deepfake’ów są konstruowane według określonych schematów marketingowo-propagandowych. W wielu kampaniach powtarza się starannie zaprojektowany schemat perswazyjny, złożony z następujących bloków:

- wprowadzenie, stanowiące osobistą, często emocjonalną historię lub rzekomo spontaniczną wypowiedź,

- opis problemu, prezentujący sytuację zagrożenia (np. choroba, inflacja, spisek),

- pobudzenie emocji – wzbudzenie strachu, złości, frustracji lub dopasowanie do potrzeb odbiorcy i prezentowanie wyidealizowanego świata,

- autorytet – przedstawienie siebie jako autorytetu, lub powołanie się na inną znaną osobę, często „poleca” rozwiązanie,

- rozwiązanie – produkt, usługa, inwestycja, która ma „uratować sytuację”,

- korzyści i dowody – fałszywe recenzje, wykresy, liczby,

- wezwanie do działania z koniecznością natychmiastowego podjęcia konkretnej decyzji, np. ściągnięcia aplikacji, wypełnienia formularza.

Stosowane techniki manipulacyjne przekazu obejmują m.in. presję czasu, ekskluzywność oferty i jej ograniczenia, np. tylko dla wybranych osób, które oglądają nagranie i najszybciej wyślą zgłoszenie przez formularz kontaktowy. Język wypowiedzi jest dopasowany do odpowiedniej grupy odbiorczej (np. wiekowej, zawodowej, związanej ze stanem zdrowia). Skuteczność manipulacji wynika z dopasowania stylu wypowiedzi, poprzez wykorzystanie:

- języka potocznego, młodzieżowego, a czasem nawet wulgarnego - głównie ukierunkowane dla odbiorców z social mediów oraz młodych osób,

- języka eksperckiego, stylizowanego na wypowiedzi specjalistów i naukowców,

- stylu podniosłego, przypominający przemówienia polityczne, kazania, świadectwa, przede wszystkim kierowany do osób starszych.

Takie treści zawierają także wiele bezpośrednich zwrotów do odbiorców: „rodacy”, „słuchajcie”, „my, zwykli ludzie”, czy odwołania do polskości: „dla Polaków”

Często pojawiają się odwołania do „realiów życia” - zmęczenia, braku czasu i pieniędzy, chorób, życia rodzinnego. Forma przypomina znane formaty – wywiady, poradniki, relacje, często imitując znane schematy: rolek TikTok, reportaż, livestream, reklamy, konsultacje online, dodatkowo obniżając czujność odbiorcy.

Dodatkowo, takie materiały mogą posiadać fałszywe opinie (rzekome komentarze internautów, wywiady uliczne, wypowiedzi innych osób, polecenia od specjalistów), oraz zapewnienie o braku ryzyka, a nawet gwarantowanie zysku lub natychmiastowego efektu. W wielu przypadkach przekaz oparty jest na narracjach spiskowych i konspiracji, teorii „ujawnionej prawdy”, odrzuceniu „oficjalnych źródeł” i przedstawieniu rozwiązania jako przełomowego, a nawet zakazanego lub ukrywanego.

Wiele fałszywych materiałów zaprojektowano jako emocjonalne huśtawki, które przeprowadzają odbiorcę przez strach (sytuacja zagrożenia) ► złość lub poczucie zdrady (ktoś nas oszukuje) ► ratunek – produkt, usługa, decyzja, którą należy podjąć natychmiast.

Tego typu narracje nie tylko zachęcają do kliknięcia – mogą też eskalować agresję, podżegać do przemocy, zachęcać do „brutalnych i natychmiastowych reakcji”, zwłaszcza gdy podszywają się pod wypowiedzi „rodaków” lub „ekspertów”.

Manipulacja formą i kontekstem

Wyróżniamy materiały jednolite, gdzie cały, jeden prawdziwy (najczęściej film) ulega manipulacji poprzez stosowanie nowej ścieżki głosowej i następuje dopasowanie ruchu ust do nowego przekazu. Deepfake’i coraz rzadziej ograniczają się do jednego nagrania i coraz częściej spotykamy złożone montaże, które obejmują kompilację wielu źródeł, gdzie zmanipulowany materiał jest przeplatany prawdziwymi filmami, materiałami stockowymi, czy wypowiedziami wielu osób. Dodatkowo występują różnorodne kolaże – stylizowane na wideorozmowy, panele ekspertów, reportaże lub albo umieszczanie osób na tle jakiejś wizualizacji. Aby zwiększyć wiarygodność, wykorzystywane są fragmenty serwisów informacyjnych, transkrypcje wypowiedzi, logotypy stacji telewizyjnych/radiowych, instytucji.

Aby ukrywać błędy i utrudniać automatyczną pracę detektorów na materiały nanoszone są dodatkowe elementy jak znaki wodne, techniki maskowania informacji w postaci szumów tekstualnych (Rys. 2) lub dźwiękowych (np. szum uliczny, piosenki, melodie, śmiechy, krzyki, szepty, dźwięki monet, banknotów, przycisków, aplikacji, migawki aparatu).

Rysunek 2. Przykładowe techniki maskowania w obszarze wizualnym występujące w fałszywych reklamach.

Dodatkowo, fałszywe materiały są umieszczane w kompilacji z długimi filmami (nawet do pół godziny) często o neutralnym charakterze, a ich celem jest utrudnienie wykrycia deepfake’a przez algorytmy.

Podsumowanie

Można przyjąć, że technologia deepfake to nowoczesna i kompleksowa broń psychologiczna. Spójnie łączy iluzję wizualną z precyzyjną manipulacją emocjami i zaufaniem. Dlatego tak ważna jest edukacja społeczeństwa. Rozumiejąc techniki manipulacji, możemy budować społeczną odporność na fałszywe treści. Natomiast, żeby skutecznie przeciwdziałać tego typu zagrożeniom, potrzebujemy reakcji na bieżące incydenty, ale również potrzebna jest długofalowa strategia, która obejmie rozwój automatycznych metod detekcji oraz regulacje prawne, programy edukacyjne i standardy odpowiedzialnego korzystania z AI